Pensándolo bien...

Las populares redes neuronales son una aproximación para resolver problemas propios del funcionamiento del cerebro. Eso no quiere decir, en modo alguno, que se trate de una analogía del propio cerebro. El aprendizaje automático tiene peculiaridades asociadas al tipo de infraestructura que soporta los modelos que se formulan. En los grandes modelos de tratamiento del lenguaje natural hay toda una categoría, según se trate de problemas que implican muchos pasos y los que requieren pocos pasos para su resolución.

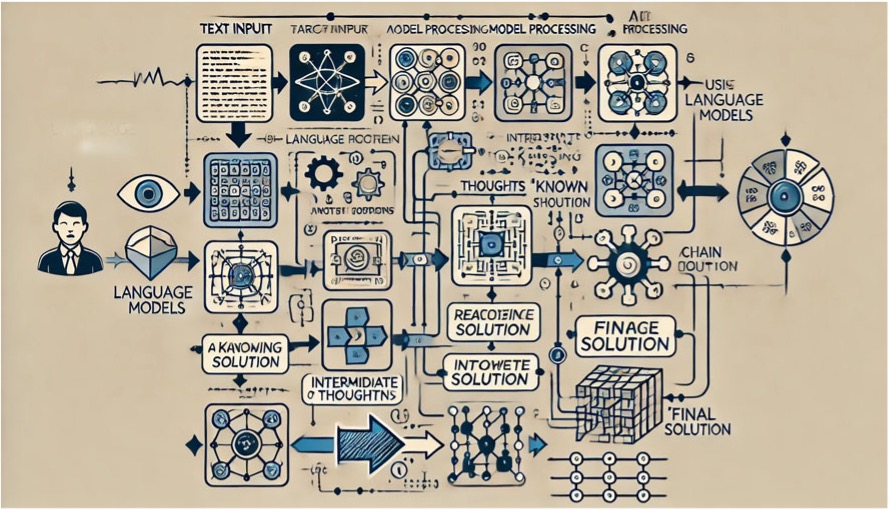

Una propuesta de 2022 formuló el denominado impulso de la “cadena de pensamiento”, que pronto se generalizó en el mundo del aprendizaje automático. El impulso de cadena de pensamiento, también conocido como flujo de conciencia, es un proceso mental continuo en el que los pensamientos, ideas y emociones fluyen libremente, llevando uno al otro de manera natural y a veces impredecible. Este concepto, que encuentra sus raíces en la psicología y la literatura, ofrece una ventana única a la complejidad del pensamiento humano, revelando cómo trabaja nuestra mente, se distrae, recuerda y se conecta con el mundo interno y externo.

El término "flujo de conciencia" fue acuñado en el ámbito de la psicología por William James a finales del siglo XIX. James lo describió como un río constante de pensamientos y sensaciones que fluyen a través de la mente. Este concepto fue adoptado y ampliado por autores y artistas en el siglo XX, quienes lo utilizaron para explorar la psique humana de manera profunda y detallada, reflejando cómo los pensamientos y sentimientos se entrelazan y cambian momento a momento.

Desde una perspectiva psicológica, el impulso de la cadena de pensamiento destaca la naturaleza no lineal y dinámica del pensamiento humano. La mente no opera en un vacío; está constantemente procesando estímulos externos e internos, haciendo conexiones, recordando experiencias pasadas y anticipando el futuro. Esta perspectiva ha informado enfoques terapéuticos como la terapia cognitivo-conductual y la terapia de aceptación y compromiso, que buscan entender y modificar los patrones de pensamiento que pueden llevar a trastornos emocionales y conductuales.

En literatura, el impulso de la “cadena de pensamiento” se ha utilizado para dar voz al monólogo interno de los personajes, ofreciendo a los lectores una perspectiva íntima de sus vidas internas. Escritores como James Joyce, Virginia Woolf y Marcel Proust son conocidos por su uso del flujo de conciencia para construir narrativas ricas y complejas que capturan la esencia de la experiencia humana. En arte, este concepto ha inspirado obras que buscan capturar la efímera y fluida naturaleza de la percepción y la emoción. Algunos autores españoles han experimentado con técnicas narrativas innovadoras como Don Ramón del Valle-Inclán. Aunque no es un purista del flujo de conciencia, su uso de la técnica del esperpento en obras como "Luces de Bohemia" refleja una intención de explorar la realidad desde múltiples perspectivas, distorsionándola para revelar una verdad más profunda. Valle-Inclán, a través de su estilización y su enfoque en los monólogos interiores, proporciona una ventana a los estados mentales y emocionales de sus personajes. Otro autor que incorporó elementos del flujo de conciencia en su obra fue Juan Benet. En su novela "Volverás a Región", Benet crea una atmósfera densa y compleja, utilizando un estilo narrativo que profundiza en los pensamientos y percepciones de sus personajes. La técnica le permite construir un mundo rico en simbolismos y enigmas, donde los monólogos interiores y las descripciones detalladas sumergen al lector en la psicología de los personajes y el entorno enigmático de Región, un territorio ficticio que sirve como escenario principal para su obra. Carmen Laforet, con su novela "Nada", también puede ser vista como una precursora en la utilización de técnicas que evocan el flujo de conciencia para narrar la experiencia interna de su protagonista, Andrea. Aunque la novela se estructura de manera más tradicional que las obras de Joyce o Woolf, el relato en primera persona permite un acercamiento íntimo a los pensamientos y emociones de Andrea, reflejando su mundo interior con una intensidad y una inmediatez que remiten al flujo de conciencia.

En la era digital, el concepto de impulso de la cadena de pensamiento encuentra nuevas aplicaciones y desafíos. Las redes sociales, por ejemplo, pueden verse como un reflejo colectivo de este flujo de conciencia, donde pensamientos, opiniones y emociones se comparten de manera constante. Sin embargo, este constante fluir de información también plantea preguntas sobre la atención, la sobrecarga de información y cómo nuestros patrones de pensamiento están siendo influenciados por la tecnología.

El impulso de cadena de pensamiento es un recordatorio de la rica complejidad de la mente humana. Aunque a veces puede parecer caótico y sin dirección, este flujo constante de pensamientos y emociones es fundamental para nuestra capacidad de reflexionar, crear y conectarnos con los demás. Al entender y apreciar este proceso, podemos comenzar a ver nuestras vidas internas no como algo que necesariamente debe ser controlado o simplificado, sino como una fuente de creatividad, empatía y comprensión profunda.

Un equipo de investigadores de Google, formularon modelos de lenguaje que generaran paso a paso desde una entrada a los modelos de resolución de problemas cuya solución era conocida. La técnica empleada fue la de cadena de pensamiento, lo que les llevó a sumergirse en la aureola teórica de la complejidad computacional. Básicamente se trataba de estudiar las capacidades intrínsecas y las limitaciones de los modelos de lenguaje.

Imagen creada con ayuda de ChatGPT con DALL-E

Las redes neuronales artificiales realizan operaciones matemáticas simples, ya que las palabras se representan mediante cadenas de números y cada palabra se transmuta al pasar a través de la red. Juega un papel decisivo los valores que cuantifican la fuerza de las conexiones entre neuronas. Para entrenar un modelo de lenguaje para que sea capaz de producir resultados razonables y, en todo caso, coherentes, los parámetros inicialmente toman valores aleatorios y a continuación se les alimenta con gran cantidad de datos, que normalmente proceden de Internet. Cuando el modelo aborda un nuevo bloque de texto, predice cada palabra de la respuesta por riguroso orden de construcción de la frase respuesta. Pronostica la segunda palabra, basándose en la primera, la siguiente en función de las anteriores y así sucesivamente. Al comparar el texto producido con el real, puede modificar los parámetros con objetivo de reducir las diferencias. Pero conforme se altera, se modifica, también, la predicción del modelo y de forma iterativa logra un efecto colectivo que se traduce en que el modelo responde de forma coherente a entradas que nunca antes ha visto.

La clave del salto cualitativo que se produjo a partir de 2017, fue la incorporación de lo que se ha dado en denominar transformador. El salto cualitativo es que, mientras que el número de parámetros hasta entonces se limitaba a unos cientos de millones, al incorporar los transformadores se ha llegado a más de mil millones de ellos. Esta ampliación es la que está tras el salto de los modelos de lenguaje hoy conocidos.

El corazón de los transformadores es el mecanismo de atención, específicamente la "atención multi-cabeza". Este mecanismo permite que el modelo preste atención a diferentes partes de la entrada al mismo tiempo, lo que facilita la captura de relaciones complejas en los datos. A diferencia de las arquitecturas anteriores, como las redes neuronales recurrentes (RNN) y las redes neuronales convolucionales (CNN), que procesan la entrada secuencialmente o en ventanas locales, la atención permite un procesamiento paralelo y global de la entrada.

Los transformadores eliminan el uso de recurrencias y convoluciones, que eran omnipresentes en los modelos de NLP (Procesado del Lenguaje Natural) anteriores. Esto no solo mejora la eficiencia del entrenamiento al facilitar la paralelización, sino que también reduce el problema del desvanecimiento de gradientes, permitiendo a los modelos manejar secuencias más largas. Dado que los transformadores no procesan los datos secuencialmente, utilizan codificaciones posicionales para mantener la noción del orden de las palabras en el texto. Estas codificaciones se suman a las representaciones de entrada, proporcionando información sobre la posición relativa o absoluta de las palabras en la secuencia.

Los transformadores originales se componen de un codificador y un decodificador. El codificador procesa la entrada completa en paralelo y transforma cada elemento de la entrada en una representación enriquecida por el contexto. El decodificador, por otro lado, genera la salida secuencialmente, utilizando tanto las salidas del codificador como las entradas anteriores del decodificador. Esta estructura es especialmente útil en tareas de traducción automática.

Los transformadores han tenido un impacto profundo en el campo del NLP, liderando al desarrollo de modelos como BERT (Bidirectional Encoder Representations from Transformers), GPT (Generative Pre-trained Transformer), y sus variantes. Estos modelos han establecido nuevos estándares de rendimiento en una variedad de tareas de NLP, incluyendo clasificación de texto, respuesta a preguntas y generación de texto.

Además, el concepto de transformadores se ha extendido más allá del NLP, encontrando aplicaciones en visión por ordenador, análisis de series temporales y otros muchos. Los investigadores han adaptado y modificado la arquitectura básica de los transformadores para satisfacer las necesidades específicas de estas diferentes áreas, demostrando la versatilidad y eficacia de los transformadores como un enfoque fundamental en el aprendizaje profundo.

En suma, los transformadores han redefinido lo que es posible en el aprendizaje automático, ofreciendo un enfoque poderoso y flexible para modelar relaciones complejas en datos en espacios de alta dimensión. Su influencia continúa creciendo, impulsando avances en una amplia gama de aplicaciones de inteligencia artificial. Sigue sin ser analogía del cerebro, pero probablemente estamos más cerca.

Las redes neuronales artificiales realizan operaciones matemáticas simples, ya que las palabras se representan mediante cadenas de números y cada palabra se transmuta al pasar a través de la red. Juega un papel decisivo los valores que cuantifican la fuerza de las conexiones entre neuronas. Para entrenar un modelo de lenguaje para que sea capaz de producir resultados razonables y, en todo caso, coherentes, los parámetros inicialmente toman valores aleatorios y a continuación se les alimenta con gran cantidad de datos, que normalmente proceden de Internet. Cuando el modelo aborda un nuevo bloque de texto, predice cada palabra de la respuesta por riguroso orden de construcción de la frase respuesta. Pronostica la segunda palabra, basándose en la primera, la siguiente en función de las anteriores y así sucesivamente. Al comparar el texto producido con el real, puede modificar los parámetros con objetivo de reducir las diferencias. Pero conforme se altera, se modifica, también, la predicción del modelo y de forma iterativa logra un efecto colectivo que se traduce en que el modelo responde de forma coherente a entradas que nunca antes ha visto.

La clave del salto cualitativo que se produjo a partir de 2017, fue la incorporación de lo que se ha dado en denominar transformador. El salto cualitativo es que, mientras que el número de parámetros hasta entonces se limitaba a unos cientos de millones, al incorporar los transformadores se ha llegado a más de mil millones de ellos. Esta ampliación es la que está tras el salto de los modelos de lenguaje hoy conocidos.

El corazón de los transformadores es el mecanismo de atención, específicamente la "atención multi-cabeza". Este mecanismo permite que el modelo preste atención a diferentes partes de la entrada al mismo tiempo, lo que facilita la captura de relaciones complejas en los datos. A diferencia de las arquitecturas anteriores, como las redes neuronales recurrentes (RNN) y las redes neuronales convolucionales (CNN), que procesan la entrada secuencialmente o en ventanas locales, la atención permite un procesamiento paralelo y global de la entrada.

Los transformadores eliminan el uso de recurrencias y convoluciones, que eran omnipresentes en los modelos de NLP (Procesado del Lenguaje Natural) anteriores. Esto no solo mejora la eficiencia del entrenamiento al facilitar la paralelización, sino que también reduce el problema del desvanecimiento de gradientes, permitiendo a los modelos manejar secuencias más largas. Dado que los transformadores no procesan los datos secuencialmente, utilizan codificaciones posicionales para mantener la noción del orden de las palabras en el texto. Estas codificaciones se suman a las representaciones de entrada, proporcionando información sobre la posición relativa o absoluta de las palabras en la secuencia.

Los transformadores originales se componen de un codificador y un decodificador. El codificador procesa la entrada completa en paralelo y transforma cada elemento de la entrada en una representación enriquecida por el contexto. El decodificador, por otro lado, genera la salida secuencialmente, utilizando tanto las salidas del codificador como las entradas anteriores del decodificador. Esta estructura es especialmente útil en tareas de traducción automática.

Los transformadores han tenido un impacto profundo en el campo del NLP, liderando al desarrollo de modelos como BERT (Bidirectional Encoder Representations from Transformers), GPT (Generative Pre-trained Transformer), y sus variantes. Estos modelos han establecido nuevos estándares de rendimiento en una variedad de tareas de NLP, incluyendo clasificación de texto, respuesta a preguntas y generación de texto.

Además, el concepto de transformadores se ha extendido más allá del NLP, encontrando aplicaciones en visión por ordenador, análisis de series temporales y otros muchos. Los investigadores han adaptado y modificado la arquitectura básica de los transformadores para satisfacer las necesidades específicas de estas diferentes áreas, demostrando la versatilidad y eficacia de los transformadores como un enfoque fundamental en el aprendizaje profundo.

En suma, los transformadores han redefinido lo que es posible en el aprendizaje automático, ofreciendo un enfoque poderoso y flexible para modelar relaciones complejas en datos en espacios de alta dimensión. Su influencia continúa creciendo, impulsando avances en una amplia gama de aplicaciones de inteligencia artificial. Sigue sin ser analogía del cerebro, pero probablemente estamos más cerca.

Las redes neuronales artificiales realizan operaciones matemáticas simples, ya que las palabras se representan mediante cadenas de números y cada palabra se transmuta al pasar a través de la red. Juega un papel decisivo los valores que cuantifican la fuerza de las conexiones entre neuronas. Para entrenar un modelo de lenguaje para que sea capaz de producir resultados razonables y, en todo caso, coherentes, los parámetros inicialmente toman valores aleatorios y a continuación se les alimenta con gran cantidad de datos, que normalmente proceden de Internet. Cuando el modelo aborda un nuevo bloque de texto, predice cada palabra de la respuesta por riguroso orden de construcción de la frase respuesta. Pronostica la segunda palabra, basándose en la primera, la siguiente en función de las anteriores y así sucesivamente. Al comparar el texto producido con el real, puede modificar los parámetros con objetivo de reducir las diferencias. Pero conforme se altera, se modifica, también, la predicción del modelo y de forma iterativa logra un efecto colectivo que se traduce en que el modelo responde de forma coherente a entradas que nunca antes ha visto.

La clave del salto cualitativo que se produjo a partir de 2017, fue la incorporación de lo que se ha dado en denominar transformador. El salto cualitativo es que, mientras que el número de parámetros hasta entonces se limitaba a unos cientos de millones, al incorporar los transformadores se ha llegado a más de mil millones de ellos. Esta ampliación es la que está tras el salto de los modelos de lenguaje hoy conocidos.

El corazón de los transformadores es el mecanismo de atención, específicamente la "atención multi-cabeza". Este mecanismo permite que el modelo preste atención a diferentes partes de la entrada al mismo tiempo, lo que facilita la captura de relaciones complejas en los datos. A diferencia de las arquitecturas anteriores, como las redes neuronales recurrentes (RNN) y las redes neuronales convolucionales (CNN), que procesan la entrada secuencialmente o en ventanas locales, la atención permite un procesamiento paralelo y global de la entrada.

Los transformadores eliminan el uso de recurrencias y convoluciones, que eran omnipresentes en los modelos de NLP (Procesado del Lenguaje Natural) anteriores. Esto no solo mejora la eficiencia del entrenamiento al facilitar la paralelización, sino que también reduce el problema del desvanecimiento de gradientes, permitiendo a los modelos manejar secuencias más largas. Dado que los transformadores no procesan los datos secuencialmente, utilizan codificaciones posicionales para mantener la noción del orden de las palabras en el texto. Estas codificaciones se suman a las representaciones de entrada, proporcionando información sobre la posición relativa o absoluta de las palabras en la secuencia.

Los transformadores originales se componen de un codificador y un decodificador. El codificador procesa la entrada completa en paralelo y transforma cada elemento de la entrada en una representación enriquecida por el contexto. El decodificador, por otro lado, genera la salida secuencialmente, utilizando tanto las salidas del codificador como las entradas anteriores del decodificador. Esta estructura es especialmente útil en tareas de traducción automática.

Los transformadores han tenido un impacto profundo en el campo del NLP, liderando al desarrollo de modelos como BERT (Bidirectional Encoder Representations from Transformers), GPT (Generative Pre-trained Transformer), y sus variantes. Estos modelos han establecido nuevos estándares de rendimiento en una variedad de tareas de NLP, incluyendo clasificación de texto, respuesta a preguntas y generación de texto.

Además, el concepto de transformadores se ha extendido más allá del NLP, encontrando aplicaciones en visión por ordenador, análisis de series temporales y otros muchos. Los investigadores han adaptado y modificado la arquitectura básica de los transformadores para satisfacer las necesidades específicas de estas diferentes áreas, demostrando la versatilidad y eficacia de los transformadores como un enfoque fundamental en el aprendizaje profundo.

En suma, los transformadores han redefinido lo que es posible en el aprendizaje automático, ofreciendo un enfoque poderoso y flexible para modelar relaciones complejas en datos en espacios de alta dimensión. Su influencia continúa creciendo, impulsando avances en una amplia gama de aplicaciones de inteligencia artificial. Sigue sin ser analogía del cerebro, pero probablemente estamos más cerca.

Sopa de letras: TRANSFORMADORES Y CEREBRO

Soluciones: EL CICLO DEL AGUA